خطاهای خطرناک چتباتها در جایگاه رواندرمانگر

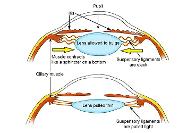

تحقیقات جدید پژوهشگران نشان می دهد چَت بات های هوش مصنوعی در نقش روان درمانگر، مرتکب خطاهای خطرناکی می شوند؛ از تأیید افکار خودکشی گرفته تا تقویت باورهای مخرب./ به گزارش ایرنا، پژوهشگران دانشگاه براون با همکاری متخصصان سلامت روان، چت بات های مبتنی بر مدل های زبانی بزرگ (LLM) از جمله چَت جی پی تی، کلود و لاما را بررسی کردند و دریافتند که این سامانه ها در نقش مشاور روانی مرتکب نقض های متعدد اخلاقی می شوند. در این پژوهش که در همایش انجمن پیشبرد هوش مصنوعی (AAAI/ACM) ارائه شد، پژوهشگران از هفت مشاور آموزش دیده خواستند تا به جای کاربران واقعی با ...

Click

To Read Full Article